En un entorno donde la privacidad es tan crítica como la innovación, las organizaciones que gestionan datos sensibles deben prepararse ya para 2026. La combinación de IA generativa, nuevas normativas europeas (como el AI Act) y una ciudadanía más consciente ha elevado el estándar de protección de datos.

Este artículo identifica los principales errores que están frenando el avance digital en sectores regulados y cómo resolverlos con tecnología real, incluyendo la anonimización automatizada, tokenización y generación de datos sintéticos con Nymiz, que ofrece hasta un 95 % de precisión en anonimización efectiva.

2025–2026: una tormenta perfecta para los datos sensibles

Un número creciente de organizaciones se enfrentan a este doble reto: proteger los datos personales y corporativos, a la vez que aprovechan todo su potencial en las iniciativas de IA. La exposición de datos no estructurados, la falta de trazabilidad y los procesos manuales siguen creando graves vulnerabilidades.

Preparar sus datos sensibles para 2026 implica adoptar un enfoque estratégico y tecnológico que combine una verdadera protección con la utilidad operativa.

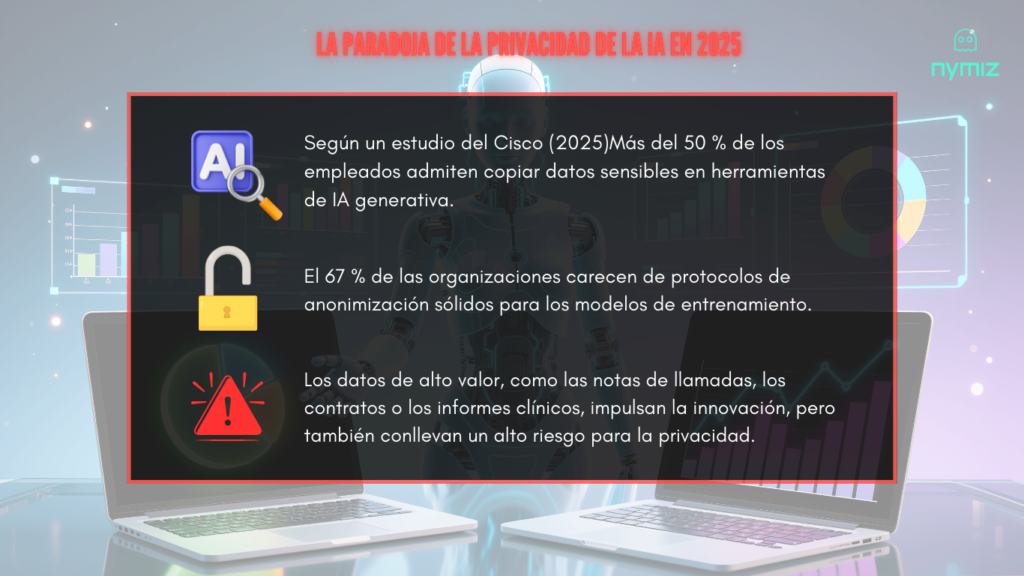

La Agencia de Ciberseguridad de la UE estima que el coste medio de una brecha de datos sensibles en sectores regulados supera los 4,45 millones de euros. Además, el 67 % de las organizaciones en Europa no cuenta con protocolos sólidos para anonimizar datos utilizados en modelos de IA (European Data Governance Report 2025).

La exposición de datos no estructurados, la falta de trazabilidad y los procesos manuales siguen generando vulnerabilidades graves. Preparar tus datos sensibles para 2026 implica adoptar un enfoque estratégico y tecnológico que combine protección real con utilidad operativa.

¿Qué puede salir mal? 5 errores críticos que debes evitar

Estos errores no son escenarios hipotéticos: están ocurriendo hoy en empresas, instituciones públicas y organizaciones que manejan información sensible sin las herramientas adecuadas. La presión por cumplir con normativas como el GDPR o el AI Act, combinada con la necesidad de explotar el valor de los datos en entornos de IA, está llevando a muchas organizaciones a tomar decisiones precipitadas o insuficientes.

A continuación, te mostramos los errores más comunes en el tratamiento de datos personales en sectores regulados, con ejemplos reales y soluciones escalables que permiten proteger sin renunciar a innovar.

1. Protección superficial = ilusión de seguridad

El problema: Una aseguradora aplica un script básico para eliminar nombres y DNIs de su base de siniestros. Meses después, un investigador externo cruza esos datos con registros de vehículos públicos y logra reidentificar a más del 30 % de los asegurados.

La consecuencia: Brecha de datos indirecta, pérdida de confianza y expediente abierto por parte de la autoridad de protección de datos.

La solución: Con Nymiz, la anonimización no se limita a ocultar campos visibles. Su motor avanzado permite definir reglas por tipo de documento y validar cada salida. En escenarios de test, ha alcanzado hasta un 95 % de precisión en anonimización efectiva.

2. Eliminar demasiado = perder el valor del dato

El problema: Un hospital elimina fechas, ubicaciones y categorías clínicas. El resultado: un dataset que ya no permite análisis longitudinales ni entrenamiento de modelos predictivos.

La consecuencia: Se sacrifica el valor analítico por miedo al incumplimiento, bloqueando proyectos de innovación.

La solución: Con Nymiz puedes generar datos sintéticos que reproducen la estructura y el comportamiento del dataset original, sin exponer información personal. Así, los modelos se entrenan sin comprometer privacidad.

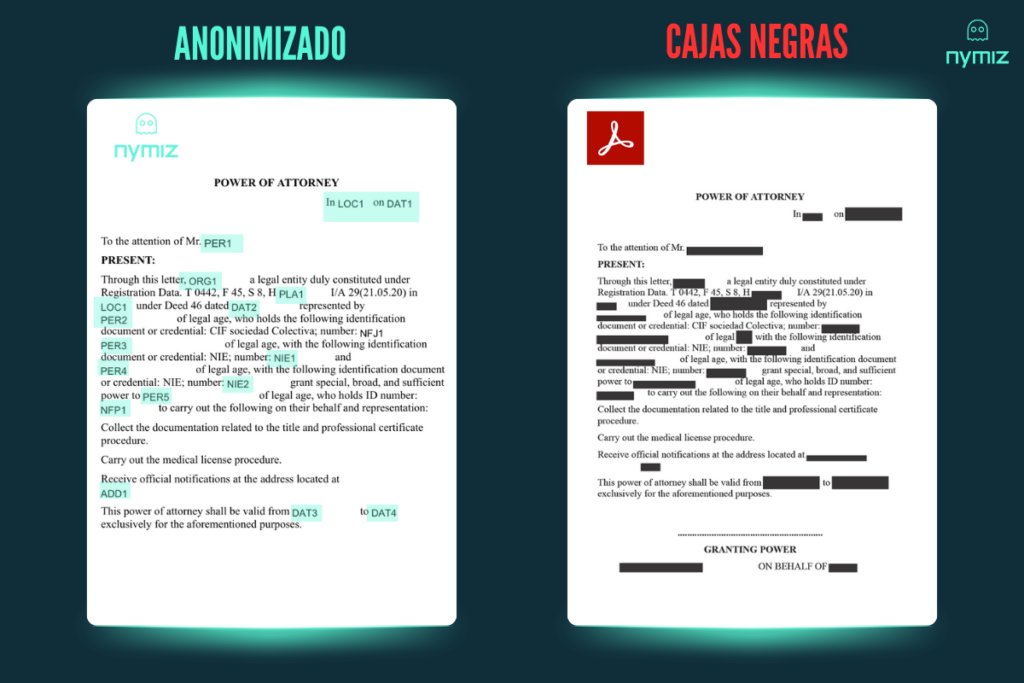

3. Procesos manuales = errores que escalan con el volumen

El problema: Un despacho de abogados anonimiza manualmente cientos de contratos. En uno, un error de copy-paste deja visibles los nombres de las partes.

La consecuencia: Exposición de información confidencial, riesgo legal y daño reputacional.

La solución: Nymiz automatiza el anonimizado por lotes, permitiendo configurar reglas por tipo documental y aplicar validaciones automáticas. Esto reduce errores, acelera procesos y libera recursos clave del equipo.

4. Anonimización sin consistencia = datos imposibles de reutilizar

El problema: Una empresa quiere cruzar datasets anonimizados de distintas fuentes. Pero los identificadores se transformaron de forma distinta, sin coherencia.

La consecuencia: Los datos no pueden integrarse, el análisis se contamina y los modelos se paralizan.

La solución: Nymiz permite aplicar tokenización consistente entre sistemas y lotes, garantizando que los datos mantengan su utilidad sin comprometer la privacidad.

5. Renunciar a la IA por miedo = ventaja competitiva perdida

El problema: Un ayuntamiento evita usar IA para analizar servicios sociales por temor a exponer datos ciudadanos.

La consecuencia: Se pierde la oportunidad de automatizar ayudas y predecir necesidades clave.

La solución: Nymiz permite generar datasets sintéticos realistas que preservan relaciones y patrones críticos, cumpliendo con GDPR y el AI Act.

Cómo preparar tus datos sensibles para 2026 sin frenar la innovación

Este modelo garantiza que sus conjuntos de datos conserven su valor analítico y minimicen el riesgo. Herramientas como Nymiz simplifican este proceso mediante la automatización y la anonimización precisa.

La privacidad no debería bloquear la IA ni la transformación digital. Con las herramientas adecuadas, las organizaciones pueden cumplir con las normativas, proteger a las personas y generar valor real.

¿Qué tecnologías usar?

- Tokenización: Para mantener la coherencia entre sistemas.

- Datos sintéticos: Para entrenar IA sin exponer datos reales.

- Procesamiento por lotes: Para escalar sin errores manuales.

- Anonimización automatizada: Para aumentar velocidad, precisión y trazabilidad.

¿Qué prácticas evitar por sector?

- Salud: Eliminar secuencias temporales o clínicas clave.

- Finanzas: Romper relaciones que afectan scoring o fraude.

- Legal: Anonimizar sin cuidar el contexto jurídico.

- Sector público: Publicar sin versionar ni medir el riesgo.

¿Cómo medir el éxito?

- Precisión en anonimización (Nymiz alcanza hasta un 95 %).

- Tiempo medio por lote procesado.

- Nivel de cumplimiento auditado.

- Utilidad del dato post-anonimización.

Casos sectoriales: del problema a la solución

Visualiza cómo diferentes sectores ya están preparando sus datos sensibles para 2026 con soluciones reales:

Salud

Reto: Compartir datos clínicos sin infringir GDPR.

Solución: Datos sintéticos basados en los reales, con patrones clínicos conservados.

Impacto: IA entrenada sin riesgo legal.

Finanzas

Reto: Compartir datos con fintechs sin exponer identidad.

Solución: Tokenización + seudonimización.

Impacto: Modelos de scoring con cumplimiento garantizado.

Legal

Reto: Entrenar un modelo jurídico con miles de documentos confidenciales.

Solución: Anonimización masiva por lotes con reglas por documento.

Impacto: IA funcional sin comprometer la privacidad.

RRHH

Reto: Analizar fuga de talento sin revelar identidades.

Solución: Seudonimización + anonimizado de atributos sensibles.

Impacto: Insights agregados sin exposición.

Sector público

Reto: Publicar datasets abiertos sin vulnerar la privacidad.

Solución: Generación de datos sintéticos a partir de datos anonimizados y versionados.

Impacto: Transparencia sin comprometer a los ciudadanos.

FAQ

-¿Qué diferencia hay entre anonimización y seudonimización?

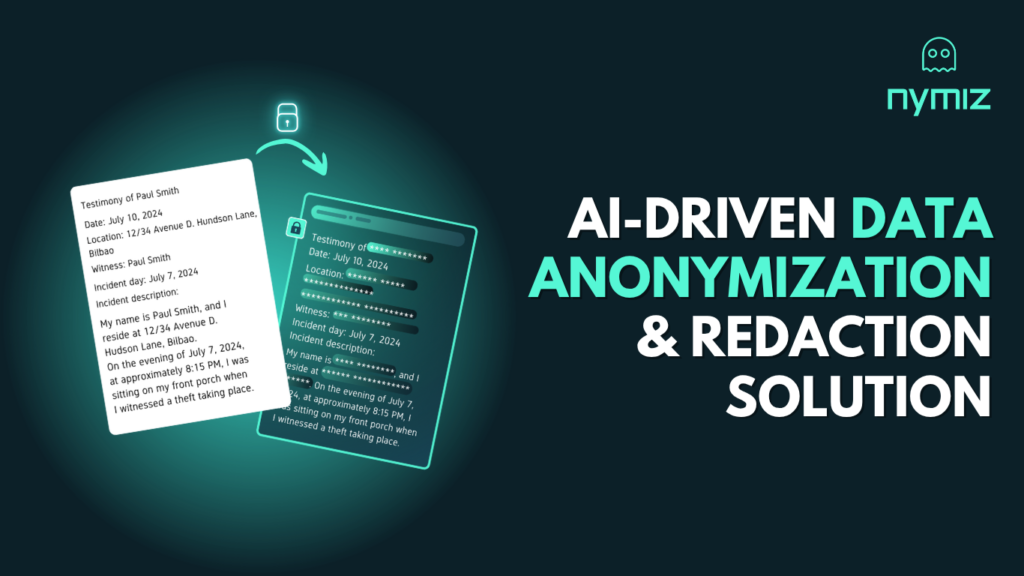

La anonimización elimina toda posibilidad de identificar a una persona. La seudonimización sustituye identificadores por claves reversibles. Los datos sintéticos son generados artificialmente sin contener información real.

-¿Puedo entrenar IA con datos anonimizados?

Sí, siempre que se conserven las correlaciones necesarias y se mantenga la utilidad del dato. Con Nymiz puedes anonimizar sin perder estructura ni coherencia.

–Diferencias entre tokenización y datos sintéticos.

Aunque ambos métodos se utilizan para proteger datos sensibles, tienen enfoques y objetivos distintos. La tokenización sustituye elementos identificables por símbolos únicos (tokens), permitiendo conservar la relación entre datos sin revelar su contenido real. Es ideal cuando necesitas mantener coherencia y trazabilidad entre sistemas. Por otro lado, los datos sintéticos se generan artificialmente a partir de patrones reales, pero no contienen información personal auténtica. Son útiles para entrenar modelos de IA, compartir datos con terceros o realizar simulaciones reales sin riesgo legal.

-¿Cómo garantiza Nymiz el cumplimiento con el GDPR y el AI Act?

Nymiz permite aplicar técnicas reconocidas por autoridades como la AEPD y ENISA, tales como la anonimización basada en riesgo, tokenización y generación de datos sintéticos. Además, permite configurar reglas específicas por tipo de dato y sector, asegurando trazabilidad y documentación para auditorías.

-¿Puedo mantener relaciones entre registros después de anonimizar?

Sí. Con la tokenización consistente de Nymiz, puedes conservar vínculos entre registros en diferentes bases de datos sin revelar identidades. Esto permite análisis y modelado sin comprometer privacidad.

-¿Qué tipo de datos se pueden anonimizar con Nymiz?

Nymiz soporta datos estructurados (bases de datos, tablas) y no estructurados (documentos legales, PDFs, textos clínicos), aplicando diferentes estrategias según el tipo de contenido y el uso posterior del dato.

-¿Puede Nymiz integrarse con mis sistemas existentes?

Sí, Nymiz ofrece opciones de integración por API y procesamiento por lotes, adaptándose tanto a entornos locales como a arquitecturas cloud.

¿Preparado para convertir la privacidad en ventaja competitiva?

Las organizaciones que se anticipan hoy a los retos de privacidad serán las que lideren la innovación mañana. Preparar tus datos sensibles para 2026 no es solo una obligación legal: es una decisión estratégica.

Con Nymiz puedes transformar tu pipeline de datos en una plataforma segura, automatizada y útil. Ya no tienes que elegir entre cumplimiento y eficiencia: puedes tener ambos.

Solicita una demo gratuita con nuestros expertos y descubre cómo una anonimización con hasta un 95 % de precisión puede impulsar tus proyectos de IA con garantías.

Recursos y referencias recomendadas

- Costes de brechas de datos y riesgos regulatorios: IBM – Informe sobre el coste de una brecha de datos 2025

- Gobernanza de datos y privacidad en IA (marco de la OCDE): OCDE – Gobernanza de datos e inteligencia artificial

- Tendencias y retos de la IA en 2025: Ditrendia – Informe IA 2025

- Anonimización efectiva en entornos de IA: Forbes – Cómo anonimizar datos para el éxito de la IA

- Investigación académica sobre privacidad en IA: ScienceDirect – Inteligencia artificial y privacidad de datos

- Estadísticas globales sobre privacidad y uso de IA: Protecto.ai – Tendencias en privacidad y uso de IA 2025

- Estudio comparativo de privacidad de datos de Cisco 2025: Comunicado de prensa de Cisco